Введите слово или словосочетание на любом языке 👆

Язык:

Перевод и анализ слов искусственным интеллектом ChatGPT

На этой странице Вы можете получить подробный анализ слова или словосочетания, произведенный с помощью лучшей на сегодняшний день технологии искусственного интеллекта:

- как употребляется слово

- частота употребления

- используется оно чаще в устной или письменной речи

- варианты перевода слова

- примеры употребления (несколько фраз с переводом)

- этимология

Что (кто) такое РЕГРЕССИЯ - определение

СТРАНИЦА ЗНАЧЕНИЙ

Найдено результатов: 36

РЕГРЕССИЯ

и, мн. нет, ж., геол.

Отступание моря при поднятии суши или опускании морского дна.||Ср. ТРАНСГРЕССИЯ.

регрессия

ж.

Отступание моря при поднятии суши или опускании морского дна.

Отступание моря при поднятии суши или опускании морского дна.

РЕГРЕССИЯ

моря , медленное ("вековое") отступание моря от берегов, происходящее вследствие поднятия суши, опускания океанического дна или уменьшения объема воды в океаническом бассейне (напр., во время ледниковых эпох). Регрессии неоднократно происходили на протяжении геологической истории, совпадая с эпохами горообразования. Современная геологическая эпоха - время регрессии, связанной с альпийским горообразованием. См. также Трансгрессия.

Регрессия

I

Регре́ссия

,

,

моря (от лат. regressio - обратное движение, отход), отступание моря от берегов. Происходит в результате поднятия суши, опускания дна океана или уменьшения объёма воды в океанических бассейнах (например, во время ледниковых эпох). Р. происходили многократно в различных районах Земли на протяжении всей её истории. См. также Трансгрессия.

II

Регре́ссия

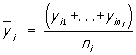

в теории вероятностей и математической статистике, зависимость среднего значения какой-либо величины от некоторой другой величины или от нескольких величин. В отличие от чисто функциональной зависимости у = f(х), когда каждому значению независимой переменной х соответствует одно определённое значение величины у, при регрессионной связи одному и тому же значению х могут соответствовать в зависимости от случая различные значения величины у. Если при каждом значении х = xi наблюдается ni, значений yi1, ...,  величины у, то зависимость средних арифметических

величины у, то зависимость средних арифметических  от xi и является Р. в статистическом понимании этого термина. Примером такого рода зависимости служит, в частности, зависимость средних диаметров сосен от их высот; см. табл. в ст. Корреляция.

от xi и является Р. в статистическом понимании этого термина. Примером такого рода зависимости служит, в частности, зависимость средних диаметров сосен от их высот; см. табл. в ст. Корреляция.

Изучение Р. в теории вероятностей основано на том, что случайные величины Х и Y, имеющие совместное распределение вероятностей, связаны вероятностной зависимостью: при каждом фиксированном значении Х = х величина Y является случайной величиной с определённым (зависящим от значения х) условным распределением вероятностей. Р. величины Y по величине Х определяется условным математическим ожиданием Y, вычисленным при условии, что Х = х:

Е(Y |х) = u(х).

Уравнение у = u(х), в котором х играет роль "независимой" переменной, называется уравнением регрессии, а соответствующий график - линией регрессии величины Y по X. Точность, с которой уравнение Р. Y по Х отражает изменение Y в среднем при изменении х, измеряется условной дисперсией величины Y, вычисленной для каждого значения Х = х:

D(Y |х) = σ2(x).

Если σ2(х) = 0 при всех значениях х, то можно с достоверностью утверждать, что Y и Х связаны строгой функциональной зависимостью Y = u(X). Если σ2(х) = 0 при всех значениях х и u(х) не зависит от х, то говорят, что Р. Y по Х отсутствует. Аналогичным образом определяется Р. Х по Y и в частности, уравнение Р. х = υ(у), = Е(Х|Y = у). Функции у = u(х) и х = υ(у), вообще говоря, не являются взаимно обратными.

Линии Р. обладают следующим замечательным свойством: среди всех действительных функций f (х) минимум математического ожидания Е[Y - f(X)]2 достигается для функции f(x) = u(х), т. е. Р. Y по Х даёт наилучшее, в указанном смысле, представление величины Y по величине X. Это свойство используется для прогноза Y по X: если значение Y непосредственно не наблюдается и эксперимент позволяет регистрировать лишь компоненту Х вектора (X, Y), то в качестве прогнозируемого значения Y используют величину u (X).

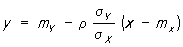

Наиболее простым является случай, когда Р. Y по Х линейна:

Е(Y|x) = β0 + β1x.

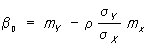

Коэффициенты β0 и β1, называются коэффициентами регрессии, определяются равенствами

где mХ и mY - математические ожидания Х и Y,  и

и  - дисперсии Х и Y, а ρ - коэффициент корреляции между Х и Y. Уравнение Р. при этом выражается формулой

- дисперсии Х и Y, а ρ - коэффициент корреляции между Х и Y. Уравнение Р. при этом выражается формулой

В случае, когда совместное распределение Х и Y нормально, обе линии Р. у = u(х) и х = υ(у) являются прямыми.

Если Р. Y по Х отлична от линейной, то последнее уравнение есть линейная аппроксимация истинного уравнения Р.: математическое ожидание Е[Y - b0 - b1X]2 достигает минимума b0 и b1 при b0 = β0 и b1 = β1. Особенно часто встречается случай уравнения Р., выражающегося линейной комбинацией тех или иных заданных функций:

у = u(Х) = β0φ0(x) + β1φ1(x) + ... + βmφm(x).

Наиболее важное значение имеет параболическая (полиномиальная) Р., при которой φ0(x) = 1 , φ1(x) = x, ..., φm(x) = xm.

Понятие Р. применимо не только к случайным величинам, но и к случайным векторам. В частности, если Y - случайная величина, а Х = (X1, ..., Xk) - случайный вектор, имеющие совместное распределение вероятностей, то Р. Y по X определяется уравнением

y = u ( x1, ..., xk),

где u( x1, ..., xk) = E{Y|X = x1, ... , Xk = xk}.

Если

u ( x1, ..., xk) = β0 + β1x1 + ... + βkxk,

то Р. называется линейной. Эта форма уравнения Р. включает в себя многие типы Р. с одной независимой переменной, в частности полиномиальная Р. Y по Х порядка k сводится к линейной Р. Y по X1, ..., Xk, если положить Xk = Xk.

Простым примером Р. Y по Х является зависимость между Y и X, которая выражается соотношением: Y = u(X) + δ, где u(x) = Е(Y IX = х), а случайные величины Х и δ независимы. Это представление полезно, когда планируется эксперимент для изучения функциональной связи у = u(х) между неслучайными величинами у и х.

На практике обычно коэффициенты Р. в уравнении у = u(х) неизвестны и их оценивают по экспериментальным данным (см. Регрессионный анализ).

Первоначально термин "Р." был употреблен английским статистиком Ф. Гальтоном (1886) в теории наследственности в следующем специальном смысле: "возвратом к среднему состоянию" (regression to mediocrity) было названо явление, состоящее в том, что дети тех родителей, рост которых превышает среднее значение на а единиц, имеют в среднем рост, превышающий среднее значение меньше чем на а единиц.

Лит.: Крамер Г., Математические методы статистики, пер. с англ., М., 1948; Кендалл М. Дж., Стьюарт А., Статистические выводы и связи, пер. с англ., М., 1973.

А. В. Прохоров.

Регрессия (психология)

ЗАЩИТНЫЙ МЕХАНИЗМ ПСИХИКИ

Психологическая регрессия

Регре́ссия ( — обратное движение) — защитный механизм, являющийся формой психологического приспособления в ситуации конфликта или тревоги, когда человек бессознательно прибегает к более ранним, менее зрелым и менее адекватным образцам поведения, которые кажутся ему гарантирующими защиту и безопасность.

Регрессия (математика)

ЗАВИСИМОСТЬ МЕЖДУ СЛУЧАЙНЫМИ ВЕЛИЧИНАМИ

Регрессия (математич.)

Регре́ссия ( — обратное движение, отход) в теории вероятностей и математической статистике — односторонняя стохастическая зависимость, устанавливающая соответствие между случайными переменными, то есть математическое выражение, отражающее связь между зависимой переменной у и независимыми переменными х при условии, что это выражение будет иметь статистическую значимость. В отличие от чисто функциональной зависимости y=f(x), когда каждому значению независимой переменной x соответствует одно определённое значение величины y, при регрессионной связи

Логистическая регрессия

СТАТИСТИЧЕСКАЯ МОДЕЛЬ, ОСНОВАННАЯ НА СРАВНЕНИИ С ЛОГИСТИЧЕСКОЙ КРИВОЙ

Logit; Логит-регрессия; Логит регрессия

Логистическая регрессия или логит-модель () — статистическая модель, используемая для прогнозирования вероятности возникновения некоторого события путём его сравнения с логистической кривой. Эта регрессия выдаёт ответ в виде вероятности бинарного события (1 или 0).

Линейная регрессия

Линейная регрессия () — используемая в статистике регрессионная модель зависимости одной (объясняемой, зависимой) переменной y от другой или нескольких других переменных (факторов, регрессоров, независимых переменных) x с линейной функцией зависимости.

Регрессия прошлой жизни

Регрессия прошлой жизни () — псевдонаучнаяPseudoscience: The Conspiracy Against Science . / Allison B.

Линейная регрессия на корреляции

Лине́йная регре́ссия на корреля́ции — частный случай линейной регрессии. Применяется для построения простейших регрессионных моделей для прогнозирования временны́х рядов.

Википедия

Регрессия

Регрессия (лат. regressio «обратное движение, возвращение»):

- Регрессия (математика)

- Регрессионный анализ — статистический метод исследования взаимосвязи переменных.

- Линейная регрессия

- Пробит регрессия

- Логистическая регрессия

- Регрессионное тестирование — собирательное название для всех видов тестирования программного обеспечения, направленных на обнаружение ошибок в уже протестированных участках исходного кода.

- Регрессия (медицина) — например, регрессия очагов эндометриоза.

- Регрессия (психология) — психологическая защита, выражающаяся в возврате к детским моделям поведения.

- Возрастная регрессия — гипнотический феномен, при котором индивид вновь переживает события из своего прошлого с такой интенсивностью, как если бы они происходили в настоящий момент.

- Регрессия (социология)

- Регрессия (экономика)

- Регрессия (фотография)

- Регрессия моря

- Регрессия прошлой жизни

- Теорема регрессии — утверждение австрийской экономической школы природе ценность денег.